Silent AI: Lokale KI-Appliance für sichere und private GenAI-Anwendungen

FAST LTA stellt mit Silent AI eine lokale, sichere Appliance für KI-gestütztes Wissens-Management vor

FAST LTA stellt mit Silent AI eine lokale, sichere Appliance für KI-gestütztes Wissens-Management vor

Neue Technologiepartnerschaft erweitert die Möglichkeiten von Extreme AI ExpertDeutlich verbesserte Wi-Fi-Konnektivität, Performanz und Sicherheit

Reply präsentiert auf der SIGGRAPH 2024 Futura, einen digitalen Reiseexperten für Costa Crociere mit NVIDIA ACE und generativer KI

AI Security Champion, AI Security for GitHub Copilot und Echtzeit-In-IDE-Code-Scanning schützen AI generierten Code und stärken das Sicherheitsbewusstsein der Entwickler

Das Technologie-, Daten- und Designunternehmen Solita und der Facility-Management-Dienstleister ISS Services entwickeln in einer der weltweit ersten Vergleichsstudien gleichzeitig dieselbe digitale Lösung.

Die neue Codierung mit kostengünstigen NVIDIA-GPUs optimiert die Verarbeitungskapazitäten von Medienunternehmen

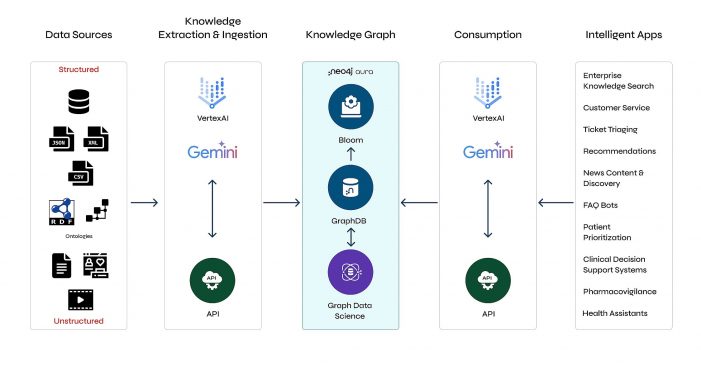

Native Integration der Graphdatenbank in die Google Cloud Platform beschleunigt Entwicklung und Deployment von GenAI-Anwendungen

Reply stellt LoopMind vor: eine Lösung zum kontrollierten und sicheren Einsatz von generativer KI in Geschäftsprozessen

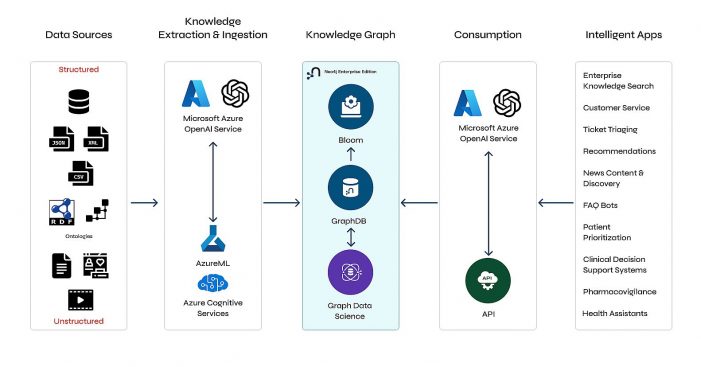

Native Integration der Graphdatenbank in die All-in-One-Analyselösung vereinheitlicht das Datenmanagement, verbessert GenAI-Ergebnisse und reduziert KI-Halluzinationen

07.03.2024 | Reply erhält AWS-Kompetenz für generative KI und stellt damit seine Expertise bei der Umsetzung branchenübergreifender Lösungen unter Beweis